京公网安备 11010802034615号

经营许可证编号:京B2-20210330

京公网安备 11010802034615号

经营许可证编号:京B2-20210330

t分布、F分布和卡方分布是统计学中常用的三种概率分布,它们分别用于样本均值的推断、方差的比较和数据的拟合优度检验。

总之这3个分布很有用,首次接触你可能理解不了,但没关系你知道很重要就行了,接着往下看,我们在介绍三大分布之前,先看一下正态分布和标准正态分布:

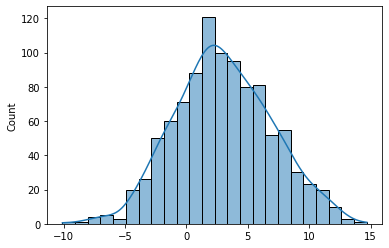

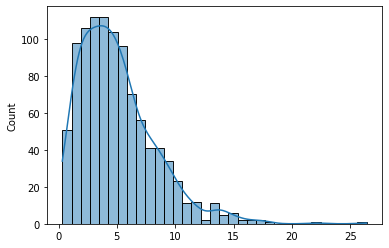

正态分布具有钟形曲线的特征,均值和标准差是其两个重要的参数。

import numpy as np

import seaborn as sns

mean = 3 # 均值

std = 4 # 标准差

size = 1000 # 生成1000个随机数

data = np.random.normal(mean, std, size=size)

sns.histplot(data, kde=True)

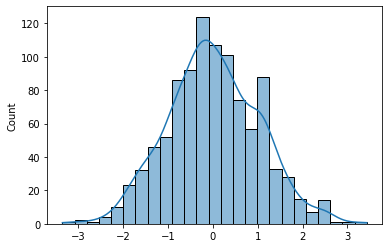

标准正态分布是一种特殊的正态分布,其均值为0,标准差为1。在统计学中,标准正态分布经常用于标准化数据或进行假设检验。

import numpy as np

import seaborn as sns

size = 1000 # 生成1000个随机数

data = np.random.standard_normal(size=size)

sns.histplot(data, kde=True)

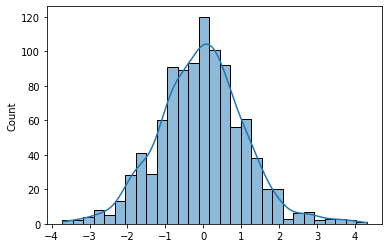

t分布是一种概率分布,用于小样本情况下对总体均值的推断。当样本容量较小或总体方差未知时,使用T分布进行推断更准确。T分布的形状类似于正态分布,但尾部较宽。T分布的自由度(degrees of freedom)决定了其形状。

import numpy as np

import seaborn as sns

df = 10 # 自由度

size = 1000 # 生成1000个随机数

data = np.random.standard_t(df, size=size)

sns.histplot(data, kde=True)

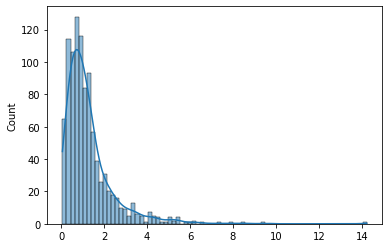

F分布是一种概率分布,用于比较两个样本方差的差异。F分布常用于方差分析和回归分析中。F分布的形状取决于两个自由度参数,分子自由度和分母自由度。

import numpy as np

import seaborn as sns

dfn = 5 # 分子自由度

dfd = 10 # 分母自由度

size = 1000 # 生成1000个随机数

data = np.random.f(dfn, dfd, size=size)

sns.histplot(data, kde=True)

卡方分布是一种概率分布,用于检验观察值与理论值之间的拟合优度。卡方分布常用于拟合优度检验、独立性检验中。卡方分布的自由度参数决定了其形状。

import numpy as np

import seaborn as sns

df = 5 # 自由度

size = 1000 # 生成1000个随机数

data = np.random.chisquare(df, size)

sns.histplot(data, kde=True)

注:本节作为延伸阅读,初学者简单了解即可

十九世纪中叶至二十世纪初,有三位统计学届杰出代表: 皮尔逊( Pearson) 、戈塞特( Gosset) 、费希尔( Fisher) 表,他们是统计学三大分布的始创者。

皮尔逊(Pearson) 在创立拟合优度理论的过程中发现了 分布;

戈塞特( Gosset) 发现 分布的过程正是 小样本理论 创立的过程;

费希尔( Fisher) 在创立 方差分析 理论的过程中发现了 分布。

这便是著名的三大抽样分布包括: 分布、 分布和 分布

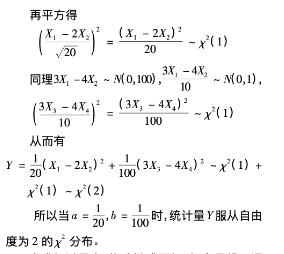

分布是由个相互独立的标准正态分布 的平方和确定的分布,记作 ~ ,即

分布的分子是一个 ,分母是自由度为 的 分布与自由度 的比值再开方确定的分布,记作 ~ ,即

分布是由两个 分布与其自由度比值的比值确定的分布 ,记 作 ~ ,即

三大分布的推导

这里分享一个你一定用得到的小程序——CDA数据分析师考试小程序。

它是专为CDA数据分析认证考试报考打造的一款小程序。可以帮你快速报名考试、查成绩、查证书、查积分,通过该小程序,考生可以享受更便捷的服务。

扫码加入CDA小程序,与圈内考生一同学习、交流、进步!

数据分析咨询请扫描二维码

若不方便扫码,搜微信号:CDAshujufenxi

第一章:数据分析思维考点1:UVCA时代的特点考点2:数据分析背后的逻辑思维方法论考点3:流程化企业的数据分析需求考点4:企业数 ...

2026-02-16在数据分析、业务决策、科学研究等领域,统计模型是连接原始数据与业务价值的核心工具——它通过对数据的规律提炼、变量关联分析 ...

2026-02-14在SQL查询实操中,SELECT * 与 SELECT 字段1, 字段2,...(指定个别字段)是最常用的两种查询方式。很多开发者在日常开发中,为了 ...

2026-02-14对CDA(Certified Data Analyst)数据分析师而言,数据分析的核心不是孤立解读单个指标数值,而是构建一套科学、完整、贴合业务 ...

2026-02-14在Power BI实操中,函数是实现数据清洗、建模计算、可视化呈现的核心工具——无论是简单的数据筛选、异常值处理,还是复杂的度量 ...

2026-02-13在互联网运营、产品迭代、用户增长等工作中,“留存率”是衡量产品核心价值、用户粘性的核心指标——而次日留存率,作为留存率体 ...

2026-02-13对CDA(Certified Data Analyst)数据分析师而言,指标是贯穿工作全流程的核心载体,更是连接原始数据与业务洞察的关键桥梁。CDA ...

2026-02-13在机器学习建模实操中,“特征选择”是提升模型性能、简化模型复杂度、解读数据逻辑的核心步骤——而随机森林(Random Forest) ...

2026-02-12在MySQL数据查询实操中,按日期分组统计是高频需求——比如统计每日用户登录量、每日订单量、每日销售额,需要按日期分组展示, ...

2026-02-12对CDA(Certified Data Analyst)数据分析师而言,描述性统计是贯穿实操全流程的核心基础,更是从“原始数据”到“初步洞察”的 ...

2026-02-12备考CDA的小伙伴,专属宠粉福利来啦! 不用拼运气抽奖,不用复杂操作,只要转发CDA真题海报到朋友圈集赞,就能免费抱走实用好礼 ...

2026-02-11在数据科学、机器学习实操中,Anaconda是必备工具——它集成了Python解释器、conda包管理器,能快速搭建独立的虚拟环境,便捷安 ...

2026-02-11在Tableau数据可视化实操中,多表连接是高频操作——无论是将“产品表”与“销量表”连接分析产品销量,还是将“用户表”与“消 ...

2026-02-11在CDA(Certified Data Analyst)数据分析师的实操体系中,统计基本概念是不可或缺的核心根基,更是连接原始数据与业务洞察的关 ...

2026-02-11在数字经济飞速发展的今天,数据已成为核心生产要素,渗透到企业运营、民生服务、科技研发等各个领域。从个人手机里的浏览记录、 ...

2026-02-10在数据分析、实验研究中,我们经常会遇到小样本配对数据的差异检验场景——比如同一组受试者用药前后的指标对比、配对分组的两组 ...

2026-02-10在结构化数据分析领域,透视分析(Pivot Analysis)是CDA(Certified Data Analyst)数据分析师最常用、最高效的核心实操方法之 ...

2026-02-10在SQL数据库实操中,字段类型的合理设置是保证数据运算、统计准确性的基础。日常开发或数据分析时,我们常会遇到这样的问题:数 ...

2026-02-09在日常办公数据分析中,Excel数据透视表是最常用的高效工具之一——它能快速对海量数据进行分类汇总、分组统计,将杂乱无章的数 ...

2026-02-09表结构数据作为结构化数据的核心载体,其“获取-加工-使用”全流程,是CDA(Certified Data Analyst)数据分析师开展专业工作的 ...

2026-02-09