京公网安备 11010802034615号

经营许可证编号:京B2-20210330

京公网安备 11010802034615号

经营许可证编号:京B2-20210330

数据

关于NMF,在隐语义模型和NMF(非负矩阵分解)已经有过介绍。

运行后输出:

可视化物品的主题分布:

结果:

从距离的角度来看,item 5和item 6比较类似;从余弦相似度角度看,item 2、5、6 比较相似,item 1、3比较相似。

可视化用户的主题分布:

结果:

从距离的角度来看,Fred、Ben、Tom的口味差不多;从余弦相似度角度看,Fred、Ben、Tom的口味还是差不多。

现在对于用户A,如何向其推荐物品呢?

方法1: 找出与用户A最相似的用户B,将B评分过的、评分较高、A没评分过的的若干物品推荐给A。

方法2: 找出用户A评分较高的若干物品,找出与这些物品相似的、且A没评分的若干物品推荐给A。

方法3: 找出用户A最感兴趣的k个主题,找出最符合这k个主题的、且A没评分的若干物品推荐给A。

方法4: 由NMF得到的两个矩阵,重建评分矩阵。例如:

运行结果:

对于Tom(评分矩阵的第2行),其未评分过的物品是item 2、item 3、item 4。item 2的推荐值是2.19148602,item 3的推荐值是1.73560797,item 4的推荐值是0,若要推荐一个物品,推荐item 2。

NMF是将非负矩阵V分解为两个非负矩阵W和H:

V=W×H

在本文上面的实现中,V对应评分矩阵,W是用户的主题分布,H是物品的主题分布。

对于有评分记录的新用户,如何得到其主题分布?

方法1: 有评分记录的新用户的评分数据放入评分矩阵中,使用NMF处理新的评分矩阵。

方法2: 物品的主题分布矩阵H保持不变,将V更换为新用户的评分组成的行向量,求W即可。

下面尝试一下方法2。

设新用户Bob的评分记录为:

运行结果是:

关于SVD的一篇好文章:强大的矩阵奇异值分解(SVD)及其应用。

相关分析与上面类似,这里就直接上代码了。

运行结果:

可视化一下:

0代表没有评分,但是上面的方法(如何推荐这一节的方法4)又确实把0看作了评分,所以最终得到的只是一个推荐值(而且总体都偏小),而无法当作预测的评分。在How do I use the SVD in collaborative filtering?有这方面的讨论。

SVD的目标是将m*n大小的矩阵A分解为三个矩阵的乘积:

[latex]

A = U S V^{T}

[/latex]

U和V都是正交矩阵,大小分别是m*m、n*n。S是一个对角矩阵,大小是m*n,对角线存放着奇异值,从左上到右下依次减小,设奇异值的数量是r。

取k,k<<r。

取得UU的前k列得到UkUk,SS的前k个奇异值对应的方形矩阵得到SkSk,VTVT的前k行得到VTkVkT,于是有

[latex]

A_{k} = U_{k} S_{k} V^{T}_{k}

[/latex]

AkAk可以认为是AA的近似。

这个算法来自下面这篇论文:

Vozalis M G, Margaritis K G. Applying SVD on Generalized Item-based Filtering[J]. IJCSA, 2006, 3(3): 27-51.

1、 设评分矩阵为R,大小为m*n,m个用户,n个物品。R中元素rijrij代表着用户uiui对物品ijij的评分。

2、 预处理R,消除掉其中未评分数据(即值为0)的评分。

计算R中每一行的平均值(平均值的计算中不包括值为0的评分),令Rfilled−in=RRfilled−in=R,然后将Rfilled−inRfilled−in中的0设置为该行的平均值。

计算R中每一列的平均值(平均值的计算中不包括值为0的评分)riri,Rfilled−inRfilled−in中的所有元素减去对应的riri,得到正规化的矩阵RnormRnorm。(norm,即normalized)。

3、 对RnormRnorm进行奇异值分解,得到:

[latex]

R_{norm} = U S V^{T}

[/latex]

4、 设正整数k,取得UU的前k列得到UkUk,SS的前k个奇异值对应的方形矩阵得到SkSk,VTVT的前k行得到VTkVkT,于是有

[latex]

R_{red} = U_{k} S_{k} V^{T}_{k}

[/latex]

red,即dimensionality reduction中的reduction。可以认为k是指最重要的k个主题。定义RredRred中元素rrijrrij用户i对物品j在矩阵RredRred中的值。

5、 [latex] U_{k} S_{k}^{\frac{1}{2}}[/latex],是用户相关的降维后的数据,其中的每行代表着对应用户在新特征空间下位置。[latex] S_{k}^{\frac{1}{2}}V^{T}_{k}[/latex],是物品相关的降维后的数据,其中的每列代表着对应物品在新特征空间下的位置。

S12k∗VTkSk12∗VkT中的元素mrijmrij代表物品j在新空间下维度i中的值,也可以认为是物品j属于主题i的程度。(共有k个主题)。

6、 获取物品之间相似度。

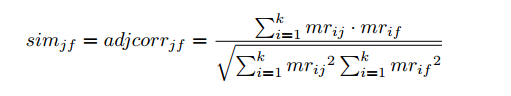

根据S12k∗VTkSk12∗VkT计算物品之间的相似度,例如使用余弦相似度计算物品j和f的相似度:

相似度计算出来后就可以得到每个物品最相似的若干物品了。

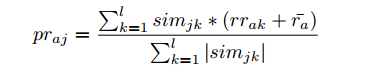

7、 使用下面的公式预测用户a对物品j的评分:

这个公式里有些变量的使用和上面的冲突了(例如k)。

ll是指取物品j最相似的ll个物品。

mrijmrij代表物品j在新空间下维度i中的值,也可以认为是物品j属于主题i的程度。

simjksimjk是物品j和物品k的相似度。

RredRred中元素rrakrrak是用户a对物品k在矩阵RredRred中对应的评分。ra¯ra¯是指用户a在评分矩阵RR中评分的平均值(平均值的计算中不包括值为0的评分)。

数据分析咨询请扫描二维码

若不方便扫码,搜微信号:CDAshujufenxi

在数据处理的全流程中,数据呈现与数据分析是两个紧密关联却截然不同的核心环节。无论是科研数据整理、企业业务复盘,还是日常数 ...

2026-03-06在数据分析、数据预处理场景中,dat文件是一种常见的二进制或文本格式数据文件,广泛应用于科研数据、工程数据、传感器数据等领 ...

2026-03-06在数据驱动决策的时代,CDA(Certified Data Analyst)数据分析师的核心价值,早已超越单纯的数据清洗与统计分析,而是通过数据 ...

2026-03-06在教学管理、培训数据统计、课程体系搭建等场景中,经常需要对课时数据进行排序并实现累加计算——比如,按课程章节排序,累加各 ...

2026-03-05在数据分析场景中,环比是衡量数据短期波动的核心指标——它通过对比“当前周期与上一个相邻周期”的数据,直观反映指标的月度、 ...

2026-03-05数据治理是数字化时代企业实现数据价值最大化的核心前提,而CDA(Certified Data Analyst)数据分析师作为数据全生命周期的核心 ...

2026-03-05在实验检测、质量控制、科研验证等场景中,“方法验证”是确保检测/分析结果可靠、可复用的核心环节——无论是新开发的检测方法 ...

2026-03-04在数据分析、科研实验、办公统计等场景中,我们常常需要对比两组数据的整体差异——比如两种营销策略的销售额差异、两种实验方案 ...

2026-03-04在数字化转型进入深水区的今天,企业对数据的依赖程度日益加深,而数据治理体系则是企业实现数据规范化、高质量化、价值化的核心 ...

2026-03-04在深度学习,尤其是卷积神经网络(CNN)的实操中,转置卷积(Transposed Convolution)是一个高频应用的操作——它核心用于实现 ...

2026-03-03在日常办公、数据分析、金融理财、科研统计等场景中,我们经常需要计算“平均值”来概括一组数据的整体水平——比如计算月度平均 ...

2026-03-03在数字化转型的浪潮中,数据已成为企业最核心的战略资产,而数据治理则是激活这份资产价值的前提——没有规范、高质量的数据治理 ...

2026-03-03在Excel办公中,数据透视表是汇总、分析繁杂数据的核心工具,我们常常通过它快速得到销售额汇总、人员统计、业绩分析等关键结果 ...

2026-03-02在日常办公和数据分析中,我们常常需要探究两个或多个数据之间的关联关系——比如销售额与广告投入是否正相关、员工出勤率与绩效 ...

2026-03-02在数字化运营中,时间序列数据是CDA(Certified Data Analyst)数据分析师最常接触的数据类型之一——每日的营收、每小时的用户 ...

2026-03-02在日常办公中,数据透视表是Excel、WPS等表格工具中最常用的数据分析利器——它能快速汇总繁杂数据、挖掘数据关联、生成直观报表 ...

2026-02-28有限元法(Finite Element Method, FEM)作为工程数值模拟的核心工具,已广泛应用于机械制造、航空航天、土木工程、生物医学等多 ...

2026-02-28在数字化时代,“以用户为中心”已成为企业运营的核心逻辑,而用户画像则是企业读懂用户、精准服务用户的关键载体。CDA(Certifi ...

2026-02-28在Python面向对象编程(OOP)中,类方法是构建模块化、可复用代码的核心载体,也是实现封装、继承、多态特性的关键工具。无论是 ...

2026-02-27在MySQL数据库优化中,索引是提升查询效率的核心手段—— 面对千万级、亿级数据量,合理创建索引能将查询时间从秒级压缩到毫秒级 ...

2026-02-27