京公网安备 11010802034615号

经营许可证编号:京B2-20210330

京公网安备 11010802034615号

经营许可证编号:京B2-20210330

如何决定样本量,是一个老生常谈的话题,也有很多相关文章。然而翻看相关文章,就会发现介绍选多少合适的比较多,而介绍为什么这么选就合适的却比较少。

相信很多用研同学都听过这句著名的话:

根据尼尔森关于可用性测试的经典理论,6-8人便可以找到产品80%以上的可用性问题。

但是……为啥呢?当有“无知的”地球人问:为什么6-8人就能发现80%以上的问题时,难道我们要理直气壮的说:因为是尼尔森说的么……

在样本量选择上似乎有一些“约定俗成”的规定。比如:可用性测试5-8人,问卷调研大约200-500份等等……但是,当需要和地球人理论时,单单的“约定俗成”却没有足够的说服力。不如让我们一起来看看这些“约定俗成”背后的科学道理,让自己更有底气。

俗话说“8个用户可以发现80%的问题”。其实这句话并不完整,完整的说法应该是:

8个人可以80%的概率发现发生可能性大于18%的问题。

这话太绕了,尝试用人话解释一下:如果某个APP中存在一个BUG,100个人用,50个人用都会遇到,那么我们至少有80%的可能性发现。只要可能遇到的人大于18个(发生可能性大于18%),我们都至少有80%的可能性发现。但如果这个BUG只有5个人可会遇到,那么能发现的概率就要低于80%了。

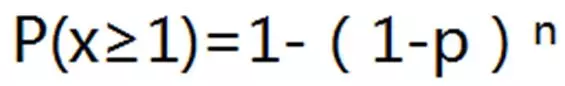

之所以这么说,背后的原理是这样一个公式:

(P(X≥1)是在n次尝试中事件至少发生1次的概率,p是某事件的概率)

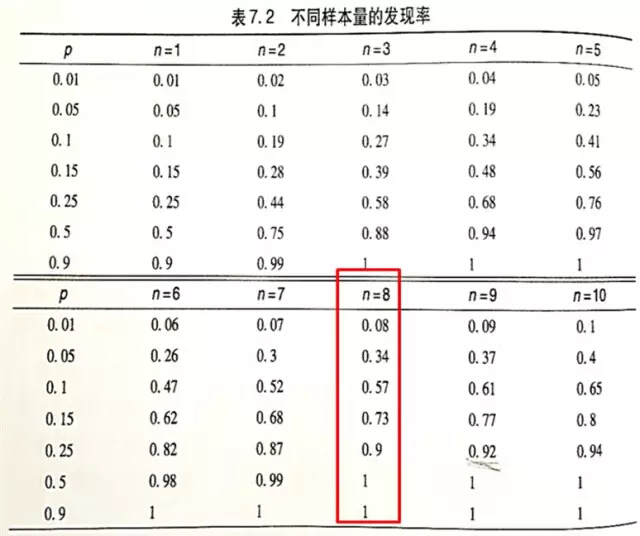

前辈们根据这个公式总结出了下表:

资料来源:《用户体验度量》Jeff Sauro,James R.Lewis著,机械工业出版社,P134-135

从表中可以看出,决定样本量涉及到两个因素:一个是确定程度,一个是问题发生的概率。

再来具体看一看我们常说的“8个人”。

当选择8个人进行测试时,可以100%发现发生概率大于50%的问题,90%的可能性发现发生概率大于25%的问题,73%的可能性发现发生概率大于15%的问题。

就好像天气预报员说:100%的确定明天的降水概率大于50%,90%的确定明天的降水概率大于25%。

等等…这样的话会不会被质疑:8个人只能90%发现发生概率大于25%的问题,那发生概率低于25%的问题怎么办?就不重要了么?

不如让我们再来看看尼尔森关于钓鱼的比喻:

假设你有好多个池塘可以钓鱼,一些鱼比另一些鱼更容易抓到。所以,如果你有10小时,你会花10个小时都在一个池塘里钓鱼,还是花5个小时在一个池塘上、花另外的5个小时在另一个池塘上呢? 为使抓到的鱼数量最大化,你应该在两个池塘上都花一些时间,以便从每个池塘里都钓到容易钓的鱼。

一次何必找那么多用户,少做几个用户先把发生率高的问题get了,版本更新以后再继续找用户去get发生率高的问题,省时省力效果佳。

这样是不是就可以完整的证明我们可用性测试做5-8个人的观点了呢。

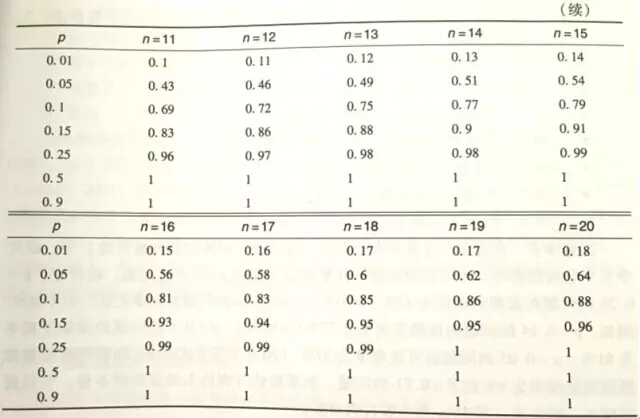

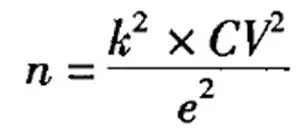

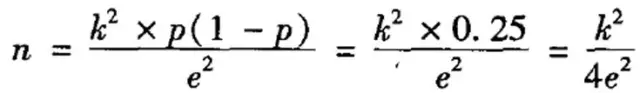

在做问卷调研的时候,如何估计样本量?众所周知有一个公式:

但是这个公式存在一个问题:我要是连总体方差(CV2)都能知道,还做个毛线调研。

如果想估算总体方差,需要先选取一批人进行测试,得到一个样本方差,用样本方差代替总体方差,这在现实工作中显然难以实现。于是为了便于计算,伟大的前辈对公式进行了转换:

资料来源:《社会研究方法》仇立平著,重庆大学出版社,P137

作者说这一转换是根据“推论总体比例或百分比的原理”进行的。姑且不去管这个转换原理是什么,这个公式我们可以这样来理解:当p=0.5的时候,总体的差异性最大。因为p=0.5表示两种情况出现的概率是相等的。比如一个群体中男生和女生出现的概率都是0.5,说明男女人数相等。这种情况下,这个群体的性别差异是最大的。

由于总体差异越大,需要的样本量就越大。我们面对任何总体的时候,都可以假设“这是一个差异性最大的总体”,来计算我们所需要的样本量。因此,把p=0.5代入,就简化出了一个可以供我们轻松计算样本量的公式。

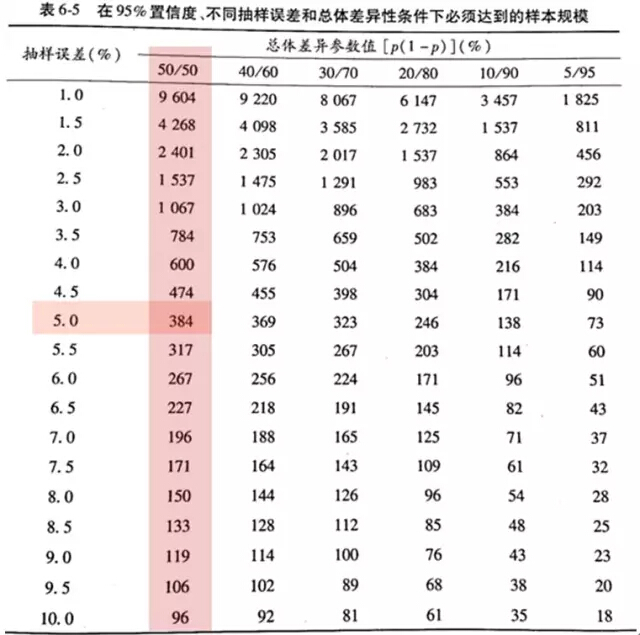

如果想看到总体不同差异所对应的样本量,前人还总结了这样一个表:

资料来源:《社会研究方法》仇立平著,重庆大学出版社,P137

因此假设总体差异性最大的情况下,在习惯使用的5%误差档,300多的样本也就可以了。

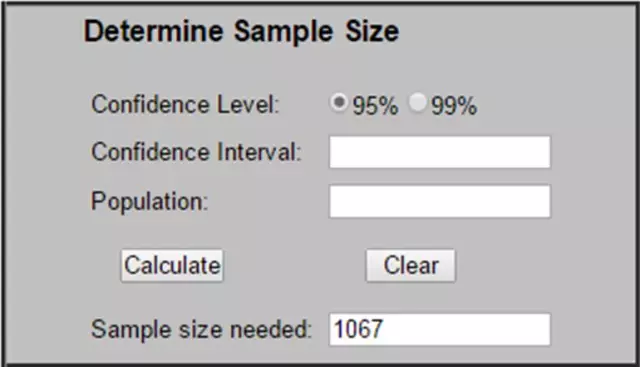

当然,在具体使用过程中,并不用查表那么麻烦。有一个著名的计算样本量的网站,直接去算就OK了。

http://www.surveysystem.com/sscalc.htm

首先,总体规模会对样本量有影响。当总体规模比较小的时候,对样本量影响较大。但是当总体规模达到一定程度以后,对样本量增加的需求是较小的。

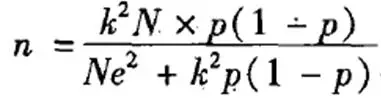

我们往往调查所涉及到的总体不是无限总体,产品的用户人数都是一个有限的数量。因此在计算所需样本量的时候,为了更精确可以加入变量“总体规模”,公式大概长成这个样子:

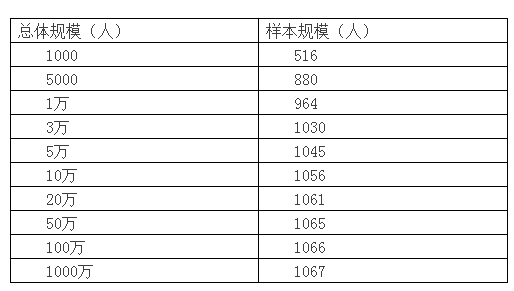

然而这不是重点,重点是通过这个公式可以计算出,不同总体规模所需要的样本量大致如下:

由此可以看出,当总体规模在1万以下时,随着总体规模上升,所需样本量增加比较大。但是当总体规模在1万以上时,规模再变大,所需样本人数的增长变得缓慢。

为了得到更准确的答案,我们不妨用计算样本量的网址自己来算一下。假设置信区间为±3个标准差。计算结果如下:

如果再有人说:我们是亿级的产品,1000人怎么能代表我们的用户?

就可以理直气壮的告诉他:

总体规模10万以上和10万所需要的样本量并没有什么区别呢。

样本量选多少合适,对于调研本身而言或许不是个问题。但是当我们想推动调研结果的时候,样本量却很容易遭到对方质疑。可能是几百个人的答案看起来容易让人觉得不靠谱,也可能因为样本量是最容易质疑的一个因素……

无论如何,多了解一些背后的原因,让自己更有底气,或许才能更好地说服别人。

数据分析咨询请扫描二维码

若不方便扫码,搜微信号:CDAshujufenxi

在 “神经网络与卡尔曼滤波融合” 的理论基础上,Python 凭借其丰富的科学计算库(NumPy、FilterPy)、深度学习框架(PyTorch、T ...

2025-10-23在工业控制、自动驾驶、机器人导航、气象预测等领域,“状态估计” 是核心任务 —— 即从含噪声的观测数据中,精准推断系统的真 ...

2025-10-23在数据分析全流程中,“数据清洗” 恰似烹饪前的食材处理:若食材(数据)腐烂变质、混杂异物(脏数据),即便拥有精湛的烹饪技 ...

2025-10-23在人工智能领域,“大模型” 已成为近年来的热点标签:从参数超 1750 亿的 GPT-3,到万亿级参数的 PaLM,再到多模态大模型 GPT-4 ...

2025-10-22在 MySQL 数据库的日常运维与开发中,“更新数据是否会影响读数据” 是一个高频疑问。这个问题的答案并非简单的 “是” 或 “否 ...

2025-10-22在企业数据分析中,“数据孤岛” 是制约分析深度的核心瓶颈 —— 用户数据散落在注册系统、APP 日志、客服记录中,订单数据分散 ...

2025-10-22在神经网络设计中,“隐藏层个数” 是决定模型能力的关键参数 —— 太少会导致 “欠拟合”(模型无法捕捉复杂数据规律,如用单隐 ...

2025-10-21在特征工程流程中,“单变量筛选” 是承上启下的关键步骤 —— 它通过分析单个特征与目标变量的关联强度,剔除无意义、冗余的特 ...

2025-10-21在数据分析全流程中,“数据读取” 常被误解为 “简单的文件打开”—— 双击 Excel、执行基础 SQL 查询即可完成。但对 CDA(Cert ...

2025-10-21在实际业务数据分析中,我们遇到的大多数数据并非理想的正态分布 —— 电商平台的用户消费金额(少数用户单次消费上万元,多数集 ...

2025-10-20在数字化交互中,用户的每一次操作 —— 从电商平台的 “浏览商品→加入购物车→查看评价→放弃下单”,到内容 APP 的 “点击短 ...

2025-10-20在数据分析的全流程中,“数据采集” 是最基础也最关键的环节 —— 如同烹饪前需备好新鲜食材,若采集的数据不完整、不准确或不 ...

2025-10-20在数据成为新时代“石油”的今天,几乎每个职场人都在焦虑: “为什么别人能用数据驱动决策、升职加薪,而我面对Excel表格却无从 ...

2025-10-18数据清洗是 “数据价值挖掘的前置关卡”—— 其核心目标是 “去除噪声、修正错误、规范格式”,但前提是不破坏数据的真实业务含 ...

2025-10-17在数据汇总分析中,透视表凭借灵活的字段重组能力成为核心工具,但原始透视表仅能呈现数值结果,缺乏对数据背景、异常原因或业务 ...

2025-10-17在企业管理中,“凭经验定策略” 的传统模式正逐渐失效 —— 金融机构靠 “研究员主观判断” 选股可能错失收益,电商靠 “运营拍 ...

2025-10-17在数据库日常操作中,INSERT INTO SELECT是实现 “批量数据迁移” 的核心 SQL 语句 —— 它能直接将一个表(或查询结果集)的数 ...

2025-10-16在机器学习建模中,“参数” 是决定模型效果的关键变量 —— 无论是线性回归的系数、随机森林的树深度,还是神经网络的权重,这 ...

2025-10-16在数字化浪潮中,“数据” 已从 “辅助决策的工具” 升级为 “驱动业务的核心资产”—— 电商平台靠用户行为数据优化推荐算法, ...

2025-10-16在大模型从实验室走向生产环境的过程中,“稳定性” 是决定其能否实用的关键 —— 一个在单轮测试中表现优异的模型,若在高并发 ...

2025-10-15